Ao se estudar as causas de um fenômeno, no intuito de entendê-lo e realizar previsões quanto ao seu comportamento, geralmente vários fatores estão envolvidos. Muitas vezes, é comum isolar a principal causa como sendo única e fazer a previsão a partir dela. No entanto, geralmente uma previsão melhor acontece quanto mais fatores causadores forem incluídos nos cálculos explicativos e preditivos do fenômenos.

A análise multivariada refere-se, basicamente, a todos os métodos estatísticos que analisam simultaneamente múltiplas medidas em cada indivíduo ou objeto sob investigação. Para ser considerado verdadeiramente multivariada, todas as variáveis devem ser aleatórias e inter-relacionadas de tal forma que seus diferentes efeitos não podem ser interpretados de maneira significativa separadamente.

Regressão linear múltipla

A regressão linear múltipla é uma técnica multivariada cuja finalidade principal é obter uma relação matemática entre uma das variáveis (a variável dependente), conhecida como preditando (ou explicada ou ainda variável de resposta), e o restante das variáveis que descrevem o sistema (variáveis independentes), também chamadas variáveis preditoras (ou explicativas ou ainda explanatórias). Sua principal aplicação é prever as mudanças na variável dependente em resposta às mudanças que ocorrem nas várias variáveis independentes, muitas vezes através do método dos mínimos quadrados.

A variável dependente pode ser expressa como a seguinte combinação linear de variáveis (X1, X2, .. Xn) com pesos empiricamente determinados (w1, w2, … wn) e um erro E:

\(Y = w_1X_1 + w_2X_2 + … + w_nX_n + E\)Essa equação pode ser escrita em forma matricial através do Modelo Linear Geral (General linear model):

\(Y_{N\times1}=X_{N\times L}\cdot B_{L\times1}+U_{N\times1}\)onde:

- Y – matriz com uma série de medidas multivariadas (várias variáveis são agrupadas para representar uma variável composta, como o grau de concordância do entrevistado em uma pesquisa de opinião sobre um procedimento do governo, também conhecida como “escala somada”);

- X – matriz de design (ou Design Matrix), com valores das variáveis explanatórias;

- B – matriz contendo os parâmetros, geralmente a serem estimados;

- U – matriz contendo erros ou ruído (devem seguir uma distribuição de Gauss multivariada).

O modelo linear geral é uma generalização do modelo de regressão linear múltipla para o caso de mais do que uma variável dependente. Se Y, B e U forem vetores coluna, a equação acima representaria regressão linear múltipla.

Exemplo

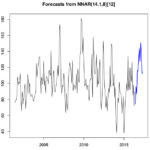

Os artigos “Correção estatística das previsões de temperatura e umidade relativa a 2 metros do Modelo Eta-15km para aprimorar as estimativas de carga do sistema elétrico” e “Refinamento estatístico das previsões horárias de temperatura a 2 m do modelo eta em estações do nordeste do Brasil” utilizam a técnica de “model output calibration” (MOC) de Mao et al. (1999). Ela usa as informações de observações e de previsões do modelo (2 a 3 semanas no passado) para avaliar e ajustar os erros de previsão atuais e produzir previsões refinadas.

No artigo, são construídas equações de Regressão Linear Múltipla, tendo como preditando a correção (chamada de delta, definida como a diferença entre o valor observado e o previsto para cada horário e para cada estação) e preditores as variáveis previstas pelo modelo de previsão meteorológica Eta, a partir de uma série de treinamento de quase 1 mês de um determinado número de estações meteorológicas. Ou seja, os dados previstos na verdade são referentes a dias/horários que já existem valores observados. Desse modo, é possível estimar os coeficientes, que depois serão utilizados para estimar os valores corrigidos.

(Atualização: os artigos utilizam todas as variáveis calculadas pelo modelo como preditores, e não as várias estações. Além disso, para selecionar os preditores, é calculada a correlação entre os valores da variável e o erro de previsão da temperatura, repetindo o procedimento para cada variável. As variáveis que possuírem um alto coeficiente de correlação são selecionadas como preditores. Tudo é calculado para cada estação separadamente. Apesar do procedimento descrito não adotar o que foi descrito nos artigos, a correção conseguiu melhorar a previsão na maioria dos horários e das estações, de modo mais significativo quando as estações utilizadas são separadas regionalmente.)

Primeiramente (e pensando na análise de apenas uma das variáveis meteorológicas, como a temperatura), os coeficientes a serem determinados formam uma matriz B de L linhas e uma coluna, onde L é o número de estações meteorológicas. Já a matriz Y contém os valores de delta distribuídos em N linhas e uma coluna, onde N é o número de passos de tempo – importante notar que os valores são correspondentes a apenas uma das estações, devendo a equação geral ser calculada para cada estação. Por fim, a matriz design X contém os valores de saída do modelo para o período em que já existem dados observados (no caso, valores de temperatura) distribuídos em N linhas e L colunas, de modo que cada coluna representa os dados de uma estação e cada linha apresenta os dados os dados de todas as estações no mesmo instante. Note que as propriedades da multiplicação de matrizes são respeitadas.

Utilizando linguagem R, o seguinte comando realiza a regressão linear múltipla:

resmodelo = lm(y ~ ., data = matriz_design)

Interpretando a saída desse comando (através de “summary(resmodelo)”), a coluna “Estimate” apresenta os coeficientes obtidos. O parâmetro (intercept) é o intercepto do plano de regressão – caso todos os outros termos dêem zero, então esse será o valor médio no ponto, não tendo qualquer outro significado como um termo separado no modelo de regressão. No caso de utilizar esse valor, a matriz design deve ter uma coluna a mais no início somente com valores unitários para multiplicar com esse coeficiente.

O coeficiente de determinação está listada como ‘adjusted R-squared’ e indica a porcentagem da variação da variável dependente pode ser explicada pelos preditores. A estatística F testa se a combinação dos preditores explica a variação na variável dependente de uma forma que é improvável de ocorrer por acaso, se a hipótese nula é verdade. O valor P, na linha inferior, é para este F-teste.

Caso dois ou mais preditores sejam colineares (linearmente dependentes em vez de independentes) entre si, a variável independente pode não ser bem estimada. Para detectar esse efeito, deve-se examinar as correlações entre as variáveis independentes e também observar a estabilidade dos coeficientes conforme outras variáveis são adicionadas ao modelo de regressão.

Podem aparecer erros do tipo “ALL X residuals are 0: no residual degrees of freedom!” e “Coefficients: (X not defined because of singularities)” quando se ajusta um modelo com mais preditores do que amostras (ou seja, linhas). Por exemplo, 6 amostras, 5 variáveis (+ intercept = 6), poderiam prever o preditando perfeitamente. Ou seja, deve-se reduzir o número de variáveis independentes ou aumentar o número de passos de tempo em Y, no caso desse exemplo. Daí pode-se estimar um número bom para preditores: o mesmo número de períodos analisados (para um conjunto de dados horários, precisaria de 2 dias de dados para 48 estações). Uma discussão sobre isso pode ser vista nesse link e nesse outro link.

Para testar outras relações além de linhas retas, basta alterar a equação na função lm (). Por exemplo, para testar um polinômio de segunda ordem, usar:

resmodelo.poly2 = lm(y ~ poly(x, 2))

A função lm() assume que os dados são normalmente distribuídos e há um ‘link’ linear entre Y e X. Já a função glm() trabalha com modelo linear geral, sendo mais flexível por considerar outras distribuições (ou “family”, como “binomial” e “poisson”).

Com os coeficientes definidos, o modelo de erros de previsão pode ser estimado a através de uma nova equação linear, usando como matriz design os dados previstos para o futuro (quando não tem os dados observados):

Y’ = X’B + U

onde

- Y’ – matriz incógnita a ser calculada

- X’ – matriz design de novos dados

- B – matriz de coeficientes obtidos com regressão

- U – matriz contendo erros ou ruído

Em R, listas e data frames devem ser convertidos em matrizes (exemplos nas duas primeiras linhas). Para realizar a multiplicação entre matrizes, utiliza-se a notação da terceira linha:

X_linha = matrix(unlist(X_linha), ncol = dim(X_linha)[2]) B = matrix(unlist(B), ncol = 1, byrow = TRUE) Y_linha = X_linha %*% B

Por fim, segundo o artigo, a previsão corrigida é obtida a partir da diferença entre o valor previsto e o erro estimado pelo modelo de correção.

Uma forma de avaliar se a correção melhorou ou piorou a previsão é através do índice SS (Skill Score), ou ganho: mede (em porcentagem) o ganho das previsões corrigidas com relação às não-corrigidas. Ele é definido por:

\(SS=\frac{E_{prev}-E_{cor}}{E_{prev}}\)onde Eprev é a Raiz do Erro Quadrático Médio (RMSE) da diferença entre o observado e o previsto pelo modelo e Ecor é a RMSE da diferença entre o observado e o corrigido.

Outras técnicas

Caso a única variável dependente for dicotômica (por exemplo: homem-mulher) ou categórica (por exemplo: alto, médio, baixo) e desta forma qualitativa, a técnica multivariada apropriada é a análise discriminante.

A análise canônica de correlação pode ser vista como uma extensão lógica da análise de regressão múltipla. Enquanto a regressão múltipla envolve uma única variável dependente, a correlação canônica envolve múltiplas variáveis dependentes. O procedimento envolve obter um conjunto de pesos para as variáveis dependentes e independentes que forneçam a correlação simples máxima entre o conjunto das variáveis dependentes e as independentes.

A Análise de variância multivariada ou MANOVA (Multivariate Analysis of Variance) pode ser utilizada para explorar simultaneamente o relacionamento entre várias variáveis categóricas independentes (normalmente referenciadas como tratamentos) e duas ou mais variáveis dependentes métricas (feitas de modo que os conteúdos podem ser identificados como diferindo em quantidade ou grau). A MANOVA é útil quando o pesquisador projeta uma situação experimental (manipulação de várias variáveis não-métricas ou tratamentos) para testar hipóteses com respeito a variância em grupos de resposta em duas ou mais variáveis dependentes métricas.

Ela representa uma extensão da análise de variância univariada ou ANOVA (Analysis of Variance). A análise multivariada de covariância ou MANCOVA (Multivariate Analysis of Covariance) também pode ser usada em conjunto com a MANOVA para remover, após o experimento, o efeito de qualquer variável independente não controlável sobre as variáveis dependentes.

Fontes

- Série Estatística Multivariada – Texto I – Prof. Dr. Lorí Viali

- Design Matrix – Wikipedia

- Multiple Regression using R – slides – Montana State University

- Interpretation of R’s lm() output – Cross Validated

One comment