Imagens do céu inteiro são amplamente usadas para monitorar o céu, especialmente na geração de energia solar. No entanto, problemas de alinhamento e interferências podem comprometer a qualidade dessas imagens, tornando essencial a detecção automática de erros. Como essas câmeras capturam até duas imagens por minuto, analisar manualmente grandes volumes de dados é inviável.

No estudo “Anomaly detection in all-sky images: An approach using robust ensemble modeling of cloud cover fraction and prediction bounds” (disponível no link), publicado em janeiro/2025 na revista “Engineering Applications of Artificial Intelligence”, os autores desenvolveram um modelo que identifica automaticamente imagens problemáticas. Ele combina diferentes técnicas de inteligência artificial, como redes neurais e algoritmos genéticos, para calcular a fração de cobertura de nuvens e detectar desvios inesperados. Isso torna possível integrar esse sistema em processos automáticos de monitoramento do céu, melhorando a qualidade dos dados utilizados em estudos climáticos e aplicações em energia solar.

Descrição do equipamento e o problema a ser enfrentado

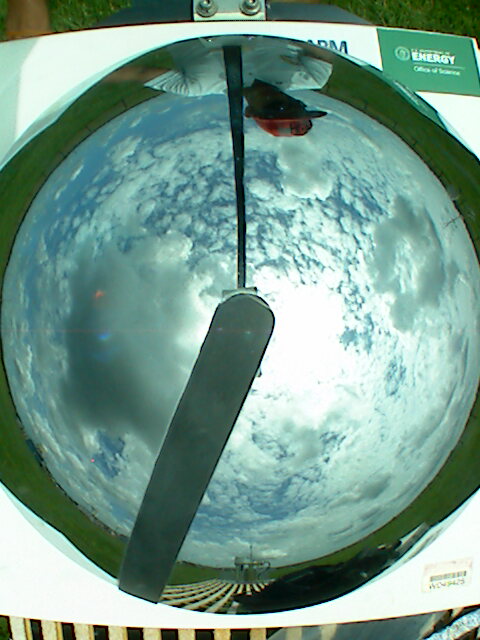

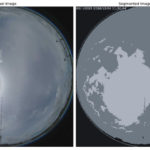

Uma imagem de céu inteiro (All-Sky Image, ASI) é uma fotografia capturada por uma câmera especial voltada para o céu, cobrindo quase 180° do campo de visão. O equipamento responsável por essas imagens é a câmera de céu inteiro (All-Sky Camera), que geralmente possui uma lente olho de peixe para capturar uma visão panorâmica do céu ou um espelho que reflete o céu com a câmera apontada para baixo. Uma das aplicações é feita por algoritmos (conjuntos de instruções) que calculam o percentual do céu visível na foto que é coberta por nuvens: a fração de cobertura de nuvens.

Para evitar que a luz intensa do sol cause superexposição e dificulte a análise das nuvens, muitas dessas câmeras utilizam um dispositivo chamado sombreador (ou máscara de ocultação), que bloqueia diretamente a luz solar, permitindo uma visualização mais clara da cobertura de nuvens sem interferências. No entanto, essa haste deve acompanhar o movimento aparente do sol no céu, o que é feito através de um mecanismo e um computador que coordena os movimentos. Deve ser feita uma calibração do equipamento para alinhar seu funcionamento com o do sol, conferido de tempos em tempos.

No trabalho de campo, uma das dificuldades é a manutenção dos equipamentos expostos ao ar livre para observar e registrar as variáveis atmosféricas. Assim, é inevitável a ocorrência de sujeiras, problemas com o alinhamento e passagens de coisas fora do escopo dos estudo (como objetos, pessoas, insetos e outros animais). Assim, a criação de um sistema automatizado que detecte essas ocorrências se faz necessário para permitir o estudo dessas imagens em grandes quantidades e com qualidade.

Estratégia para resolver o problema

Um modelo matemático é uma representação simplificada da realidade usando equações e regras matemáticas para descrever como um sistema funciona. Ele pode prever o comportamento de algo com base em certas condições. Essas equações e regras podem ser definidas com base em leis conhecidas da natureza, o que é conhecido como modelo físico, ou com base nos próprios dados e as relações entre as variáveis observando exemplos já obtidos, modelo esse obtido através da aprendizagem de dados.

A ideia central aplicada nesse estudo é a de criar um modelo matemático para estimar uma variável que caracterize cada uma das imagens analisadas e compare esses valores obtidos com os calculados por um algoritmo do próprio equipamento. Quanto maior a diferença entre esses valores, maior a chance de existir algum problema com a imagem. Além do modelo desenvolvido servir com esse propósito, ele também permite aprimorar os valores obtidos por considerar parâmteros diferentes das imagens.

Uma imagem digital é formada por pixels, que são pequenos pontos organizados em uma grade. Cada pixel armazena informações de cor em formatos como o RGB (vermelho, verde e azul, para imagens coloridas) ou a escala de cinza (um único valor em cada pixel, para imagens monocromáticas). Algumas características podem ser extraídas de uma imagem com base nos valores dos pixels, como o histograma de cores (distribuição das intensidades), textura (padrões de variação nos pixels, como contraste e rugosidade), bordas e contornos (detecção de formas e objetos) e momentos estatísticos (médias, variâncias e outras características que resumem a distribuição dos pixels).

Essas características extraídas das imagens são utilizadas como entradas para Redes Neurais de Função de Base Radial (RBF). As redes neurais funcionam como um intermediário entre entradas e saídas, onde cada neurônio artificial da camada oculta ativa uma função. Uma função matemática recebe uma ou mais entradas, aplica uma regra ou operação a elas e retorna um resultado, como uma máquina que transforma ingredientes (números) em um prato final (outro número ou valor). Neste caso, é a função de base radial, que responde mais fortemente a pontos próximos no espaço de entrada e mais fraca a pontos distantes.

Em uma rede neural, camadas são conjuntos de neurônios que processam informações em etapas, e pesos são números que ajustam a importância de cada conexão entre neurônios; na camada de saída, os pesos determinam como as respostas dos neurônios anteriores se combinam para produzir o resultado final da rede. A configuração de uma rede neural desse tipo envolve o número de neurônios e pesos da camada de saída, assim como propriedades matemáticas específicas de uma função radial.

O desenho de cada RBF é realizado por meio de uma ferramenta chamada Algoritmo Genético Multi-Objetivo (MOGA). O MOGA é um método de otimização que encontra soluções equilibradas para problemas com vários objetivos conflitantes, como tentar construir um carro que seja ao mesmo tempo rápido e econômico. Ele se baseia na ideia da evolução natural, onde um conjunto de soluções é testado, as melhores são selecionadas e combinadas para criar novas soluções, repetindo esse processo várias vezes até encontrar as mais eficientes.

Os dados de entrada no MOGA foram organizados em conjuntos de dados de treinamento, teste e validação. Assim como aprendemos um conteúdo novo estudando, um modelo de inteligência artificial também deve usar um conjunto de dados para aprender através do receonhecimento de padrões, que é chamando de dados de treinamento. Os dados de validação servem para testar o modelo durante o treinamento, ajudando a ajustar configurações e evitar que ele fique muito específico para os dados de treino. Os dados de teste, que o modelo nunca viu antes, são usados no final para medir seu desempenho real, garantindo que ele funcione bem em novos casos.

Ainda existe uma seleção de dados para compor esses conjuntos, obtidos por meio da ferramenta de seleção de dados chamada ApproxHull, que é um tipo de técnica conhecia como Convex Hull (ou envoltória convexa). Nessa técnica, a envoltória de um conjunto de pontos é a menor “casca” convexa que envolve todos esses pontos, como se colocássemos um elástico em volta deles e ele se ajustasse ao redor de forma justa. Imagine espalhar alguns pregos em uma tábua e depois prender um elástico ao redor deles — o formato final do elástico representa a envoltória convexa.

O ApproxHull tem como objetivo selecionar os dados mais importantes para representar o conjunto de dados, permitindo que o modelo aprenda mais rápido e usando menos recursos computacionais. A estratégia completa usada nesse estudo também inclui uma seleção de quais características das imagens que são mais importantes para gerar modelos através de histogramas de contagens do número de vezes que cada uma característica foi usada para gerar um ou mais modelos.

Por fim, um modelo robusto de conjunto é criado com base nos resultados do MOGA. Isso é feito primeiramente calculando as métricas de desempenho do modelo, basicamente relacionadas com o erro: diferença entre cada valor calculado pelo modelo e o observado em realidade (ou, nesse caso, estimado pelo algoritmo do equipamento de referência). Depois, uma seleção dos melhores modelos é escolhida com base nos objetivos e limiares escolhidos, e uma mediana é calculada com esses resultados, gerando o modelo de conjunto final.

Esse método de conjunto fornece uma largura média dos limites de predição, que varia conforme o nível de confiança especificado pelo usuário. Usando o limite de predição e o nível de confiança, é possível detectar anomalias nos conjuntos de imagens.

Detecção de anomalias em si

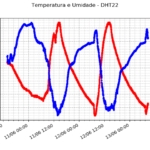

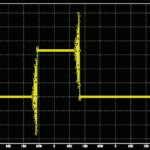

A detecção de anomalias nas imagens é feita através do cálculo de um intervalo de predição, que é uma faixa onde se espera que um novo valor de fração de cobertura de nuvens caia, com um determinado nível de confiança. Esse intervalo é calculado a partir das previsões feitas pelo modelo e, se um valor real estiver fora dessa faixa, isso é considerado uma violação.

A quantidade de violações em um dia é então comparada com o nível de confiança usado para determinar se o dia é anômalo ou não. Se as violações forem muitas, isso significa que as previsões não estão funcionando bem e o dia é classificado como anômalo, ou seja, com dados suspeitos ou problemas no sistema.

A métrica usada para essa análise e que indica a confiabilidade das previsões é a probabilidade de cobertura do intervalo (PICP). Foi definido um limite para o PICP, abaixo do qual um dia é marcado como anômalo, indicando a necessidade de revisão ou manutenção na qualidade das imagens. Um PICP alto significa que a maioria dos valores reais está dentro do intervalo de predição, o que sugere que as previsões estão precisas e os dados são confiáveis. Por outro lado, um PICP baixo indica que as previsões não estão acertando bem os valores reais, o que pode sinalizar a necessidade de investigação ou manutenção do sistema.

Resultados

Ao verificar os valores das métricas calculadas para medir o desempenho do modelo final, verificou-se que algoritmo desse estudo gera um conjunto de modelos que generaliza bem. Os baixos erros médios indicam alta precisão na previsão da fração de cobertura de nuvens para os dados de validação e bons dados. Já para o conjunto de dados sabidamente com interferências, a discrepância nos erros evidenciam a influência de imagens que não estavam nos conformes.

Com base nos valores diários de PICP, foi possível avaliar como o sistema detecta anomalias nas imagens processadas. A partir dessas classificações, foi criada uma tabela comparando os acertos e erros do sistema, permitindo calcular métricas de desempenho. Verificou-se que o método tem alta taxa de acerto geral, mas uma dificuldade em evitar falsos alertas. No entanto, em um contexto de monitoramento, é preferível que o modelo seja conservador, sinalizando a maioria dos casos com problemas potenciais, mesmo às custas de alertas desnecessários.

Operacionalmente, é possível rodar esse script ao final de cada dia. Valores baixos de PICP estimulam investigação ou manutenção adicionais, garantindo qualidade de imagem para monitoramento preciso baseado em ASI. Valores altos de PICP dão suporte a operações suaves, reforçando a confiabilidade de decisões baseadas em dados.

Excelente artigo, Vini! Muitíssimo interessante (e importante) essa pesquisa!

Oi Jana, que bom que gostou do artigo! Sua divulgação científica é muito boa, obrigado pelo comentário.